回帰分析とは②

こんにちは!EMです^^

今回は回帰分析の第2弾という事でやっていきたいと思います。

まず線形回帰について触れていきたいと思います。

線形回帰とは、最小二乗回帰(OLS: Ordinary Least Squares)とも呼ばれています。

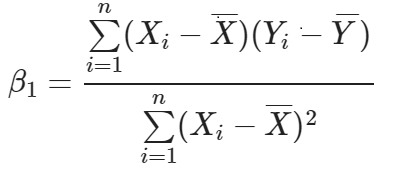

最適な線からの二乗の差を最小化にしたいときに使われ、下記のような

係数を直接計算できる線形回帰の方程式を利用します。

(数学的には closed-form solutionというそうです。)

傾きが分かれば、切片も計算できます。

残差(Residuals)

線形回帰をもう少し理解する為のもう1つの方法は

グラフに線を引いて、その線への残差平方和を最小化するという事です。

少し数学的な話がでてきたので、特に初心者の方からすると

一気に難易度があがったかと思います。

でも回帰分析を理解する上で、基礎を抑えるのはとても重要です。

今日はここまでにして、また次にも回帰分析について説明を加えたいと思います。

ちなみに皆様に朗報です!

私今まで知らなかったんですが、CodeCampさんが無料で5回分無料レッスンを

されているらしいです、、、!

私が他のオンラインスクールで機械学習のコースを受講した際は

グループレッスンで約2倍のお値段を払ったので

完全マンツーマンでこのお値段は超良心的だなと思います。。。

ぜひ気になる方は無料体験もされてるみたいなので、一度WEBサイトを見てみてくださいね。

データ分析は時代が変化しても、必ず重宝される分野だと思っているので

プロから基礎を学ぶのは、本当に超効率的な自己投資だと思います。

ではまた~^^